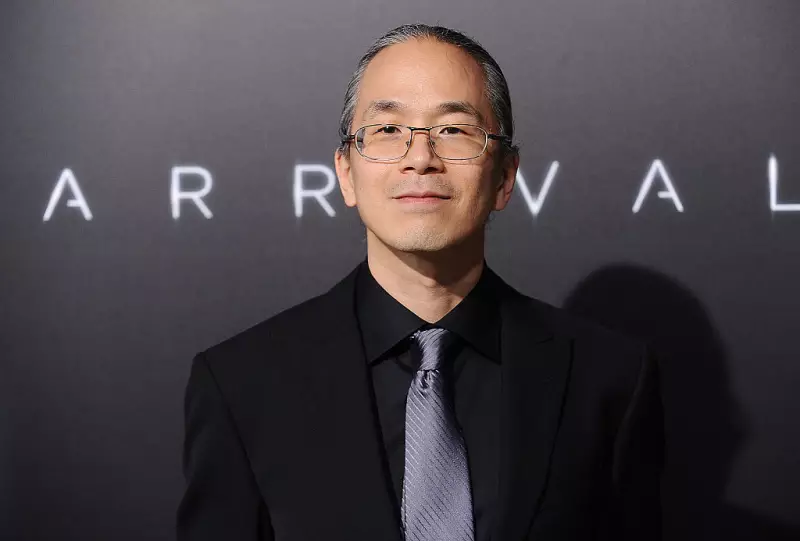

Parece que todo mundo hoje em dia fala de inteligência artificial como se fosse um colega de trabalho — ou pior, um substituto humano. Ted Chiang, aquele gênio por trás de histórias que dão nó no cérebro (já leu A História da Sua Vida?), soltou um alerta que deveria estar em letras garrafais: IA não é gente. Ponto final.

E não é só um detalhe filosófico. A forma como tratamos essas máquinas superinteligentes — ou nem tão inteligentes assim — diz muito sobre os riscos que estamos dispostos a correr. Você já parou pra pensar por que chamamos um chatbot de "ele" ou "ela" como se tivesse alma?

O perigo da personificação

Chiang, que tem o dom de explicar conceitos complexos como quem conta causo de boteco, esmiúça o problema:

- Atribuir emoções a sistemas que só processam dados

- Confundir respostas estatísticas com compreensão genuína

- Acreditar que máquinas "querem" algo — spoiler: não querem

"É como achar que seu GPS te odeia quando manda você por uma rua esquisita", brinca ele, com aquela sagacidade que só quem entende do riscado consegue ter.

Por que caímos nessa?

Nosso cérebro tá programado pra ver humanidade em tudo — desde nuvens com formato de rosto até robôs que mal conseguem manter uma conversa coerente. A indústria tecnológica adora essa confusão, claro. Vendem assistentes virtuais com voas "amigáveis" como se fossem ajudantes mágicos, não produtos cuidadosamente projetados para engajar (e às vezes enganar) usuários.

E aqui vem o pulo do gato: quando tratamos IA como gente, começamos a:

- Superestimar suas capacidades

- Subestimar seus riscos

- Justificar erros como "ela tá aprendendo" — como se fosse uma criança, não um algoritmo

Chiang lembra que até os sistemas mais avançados hoje são basicamente "papagãos estatísticos" (expressão dele, não minha). Geram textos convincentes? Sim. Entendem o que dizem? Nem de longe.

O futuro que (não) queremos

O perigo real, segundo o escritor, não é a IA se rebelar como nos filmes. É a gente abrir mão de responsabilidades — desde decisões médicas até sentenças judiciais — pra sistemas que não têm a menor noção do que estão fazendo.

"Chamar um modelo de linguagem de inteligente é como chamar um balão de helicóptero", dispara Chiang. Ambos voam, mas de formas radicalmente diferentes. E se você pular de um prédio confiando num balão... bom, você entendeu.

No final das contas, a reflexão de Chiang serve de antídoto pra tanto hype vazio. Tecnologia avança, mas discernimento humano não pode ser opcional. Como ele mesmo diz: "Máquinas processam informação. Pessoas vivem experiências. Não confunda os dois".